Mesmo que você não trabalhe com tecnologia ou não tenha tanto envolvimento com a área no dia a dia para além do uso de redes sociais e outros aplicativos, talvez você tenha ouvido muito falar sobre inteligência artificial ao longo deste início de 2023. Isso porque uma nova ferramenta tornou-se popular por responder a quase qualquer pergunta com um texto que parece ter sido escrito por uma pessoa.

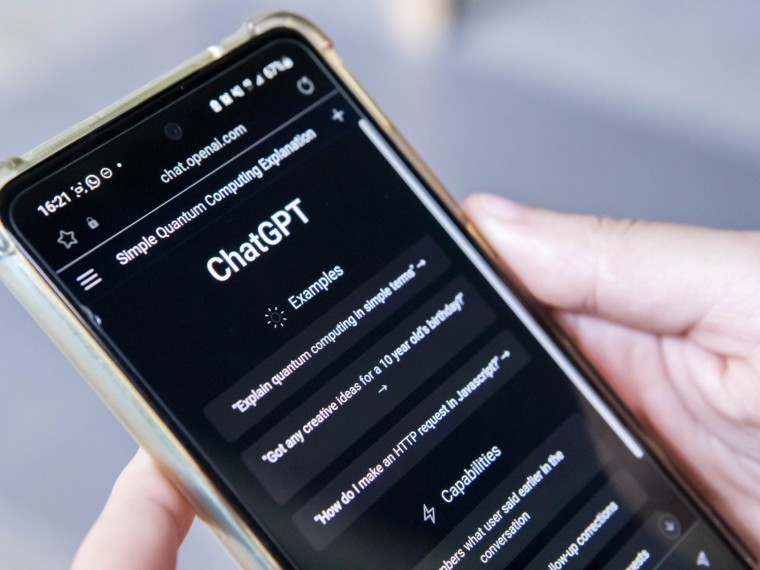

Trata-se do ChatGPT, uma inteligência artificial (IA) generativa criada pela empresa norte-americana OpenAI — que teve Elon Musk, atual dono do Twitter, como um dos primeiros investidores. Com uma conta na plataforma, o usuário pode fazer perguntas ou solicitar que o robô escreva algo e, em segundos, receber uma resposta da máquina. Bastaram cinco dias para a ferramenta atingir um milhão de usuários, tamanho o alcance que teve.

Na última sexta-feira, 10, foi lançado no Brasil o ChatGPT "plus", pacote de assinaturas que custa US$ 20 (certa de R$ 103,50) e permite que o usuário tenha acesso à plataforma mesmo em horários de alta demanda.

Em meio ao sucesso da novidade lançada em novembro de 2022, a Microsoft anunciou, no final de janeiro, novo investimento bilionário na OpenAI. Já em 6 de fevereiro deste ano, o Google anunciou o lançamento do Bard, chatbot inteligente alimentado pelo LaMDA (Language Model for Dialogue Applications). “(O Bard) é baseado em informações da web para fornecer respostas novas e de alta qualidade”, afirmou Sundar Pichai, CEO do Google, em publicação no blog da empresa.

Ao mesmo tempo que muitos ficaram animados, logo começaram a surgir as preocupações com possíveis malefícios decorrentes do uso da ferramenta. Uma delas é que o plágio em trabalhos escolares e acadêmicos pode tornar-se ainda mais difícil de ser descoberto. Nesse contexto, universidades — assim como a própria OpenAI — já têm buscado desenvolver detectores de textos gerados por inteligência artificial.

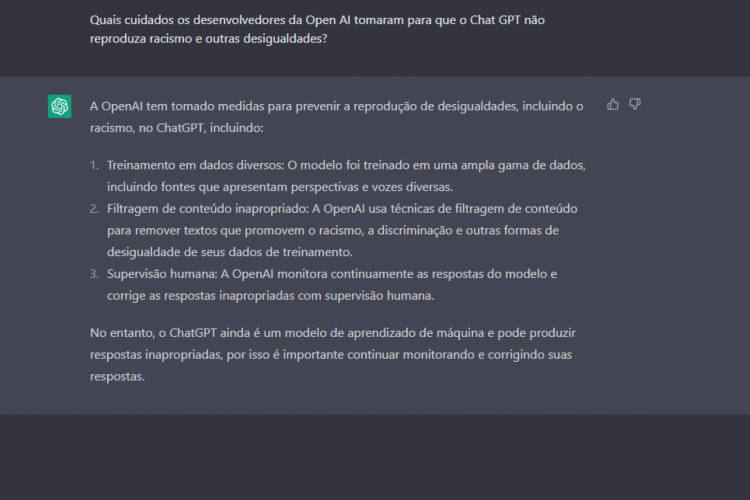

Ao fazer o login para testar a ferramenta, o usuário depara-se com exemplos do que perguntar ao ChatGPT, informações sobre o que ele consegue fazer e quais as limitações dele. Ele consegue, por exemplo, lembrar o que foi dito anteriormente em uma “conversa” e permite que o usuário o corrija. Mas a empresa também alerta que ele pode fornecer informações incorretas e produzir conteúdo tendencioso, além de as informações sobre eventos após 2021 serem limitadas.

Como foi abordado no O POVO na reportagem ChatGPT: A criatura pode superar o criador?, ferramentas como o ChatGPT possibilitam a automatização de atividades corriqueiras. Pelo Twitter, diversas experiências feitas com a IA foram compartilhadas entre os usuários, tanto entre quem a levou a sério para explorar a utilidade para o dia a dia, quanto entre aqueles que tentaram desafiá-la ou apenas brincar com as possibilidades que ela oferece.

Escrever e-mails, poemas e músicas, tirar dúvidas sobre tópicos específicos, escrever códigos de programação e criar roteiro de viagem foram algumas delas. Alguns jornalistas inclusive entrevistaram a própria ferramenta.

Outro aspecto que preocupa a cientista da computação Nina da Hora é o impacto — para ela, mais negativo do que positivo — que a IA pode causar na Educação. Esse momento em que está “todo mundo testando e achando uma grande mágica” reduziria a seriedade do debate de que aprender leva tempo.

“A ideia dessas inteligências artificiais dá a entender que você consegue aprender as coisas muito rápido, e na minha perspectiva aprender de verdade leva tempo, é uma construção da base do conhecimento com o ser humano. A minha preocupação é justamente que ela esteja fazendo uma confusão com a geração que está chegando agora, com a (atual) geração”, afirma.

Como a interação com o ChatGPT não é uma mágica, que tal dar um passo atrás na discussão e entender o que é inteligência artificial e como ela está inserida no dia a dia?

Antes de tudo, há o conceito de algoritmo. Ele pode ser entendido como uma sequência de instruções, como uma receita, um passo a passo para se chegar de um lugar a outro ou executar uma tarefa. Quando se cria algoritmos associados a um aprendizado, pode-se chegar a resultados em que as máquinas tenham tomado decisões que lembram as que o cérebro humano poderia tomar, explica Nina da Hora.

O advogado André Lucas Fernandes, diretor do Instituto de Pesquisa em Direito e Tecnologia do Recife (IP.rec), acrescenta que em uma inteligência artificial essa “receita” lida com um grande volume de dados e o seu comando deixa de ser apenas um algoritmo.

“Ela tem como resultado final uma conclusão da qual o próprio algoritmo se retroalimenta. Entre muitas aspas, ela ‘aprende’”, complementa Fernandes, que é pesquisador e coordenador do ponto focal sobre IA na Coalizão Direitos na Rede. Dessa forma, os dados utilizados para treinar o algoritmo vão interferir no que ele vai produzir como resultado.

Nina da Hora aponta, porém, que há uma discussão sobre o próprio nome “inteligência artificial”, se deve ser utilizado no singular ou no plural. “Até a palavra inteligência ainda tem um grande confusão de definição, se realmente nós podemos criar uma forma de imitar o cérebro humano ou as associações que o cérebro humano faz”, complementa.

A cientista da computação afirma que se costuma associar inteligência artificial à robótica, mas frisa que um robô existe sem inteligência artificial e ela existe sem um robô.

“Quando se faz essa associação entre robótica e inteligência artificial, deixa-se de explicar que, quando associamos os dois, temos algumas peças eletrônicas que contribuem para que o robô consiga absorver o aprendizado, a percepção, a decisão”, complementa. É o caso de carros autônomos, em que algoritmos de visão computacional contribuem para a percepção do ambiente.

Possuem sensores com algoritmos de visão computacional que auxiliam na percepção do ambiente.

Alguns utilizam IA para o atendimento virtual ao cliente e para outras análises.

A IA tem sido utilizada para tornar o recrutamento mais assertivo, mas há casos em que o viés do algoritmo interferiu na seleção.

Empresas utilizam IA para avaliar dados dos clientes e definir perfil deles.

Uma das aplicações tem sido o reconhecimento facial, que já levaram pessoas negras a serem presas por erro do viés algorítmico.

Uma das áreas em que a IA já é utilizada é na medicina diagnóstica, auxiliando os profissionais a identificarem possíveis resultados em exames de pacientes.

Nesse contexto, o ChatGPT está inserido em uma das áreas que fazem parte da inteligência artificial: o processamento de linguagem natural (NLP, na sigla em inglês). Ele foi desenvolvido a partir do Generative Pre-Training Transformer 3 (GPT-3), modelo criado pela mesma OpenAI e lançado em junho de 2020.

Para conseguir responder às perguntas dos usuários, o modelo foi treinado com uma enorme base de dados textual para “aprender” a encontrar os padrões que fazem sentido na criação das frases.

No mercado existem outros exemplos de grandes modelos de linguagem — ou large language models (LLM) —, como o LaMDA, da Google. Além disso, há ferramentas pagas que geram textos automáticos. Conheça outras plataformas de IA.

“Em termos de tecnologia, ele não é uma inovação”, aponta Fernandes, que, por outro lado, destaca a rapidez na resposta do ChatGPT na tela do usuário como um avanço entre esses LLM e como diferencial para o sucesso da ferramenta. “O segundo ponto (de virada) é que a empresa fez uma jogada de marketing mesmo”, complementa.

A reação inicial nas redes sociais ao ChatGPT tem sido similar ao que foi visto nas com o Lensa, que viralizou nas no final de 2022. O aplicativo de edição de fotos ganhou visibilidade ao lançar o “avatares mágicos”, funcionalidade que cria ilustrações em diferentes estilos artísticos com uso de IA a partir de fotos fornecidas pelo usuário.

As duas ferramentas partem de dados — textuais ou imagéticos — para criar novos conteúdos. E cada vez que os usuários enviam novos dados, seja por meio de perguntas ou fotos, elas estão sendo treinadas para fazer novas associações. E assim como no caso do texto, a criação de imagens por IA tem levantado questionamentos por conta do direito autoral.

“As repercussões dessas tecnologias começam a aparecer com a gente já usando. O setor de tecnologia chama isso de iteração. ‘Faça primeiro, peça desculpas depois’. Você tenta, erra, tenta de novo”, afirma André Lucas Fernandes.

“É bem preocupante porque nós estamos colocando ali perguntas ou solicitando temas, dando informações que não sabemos para onde estão indo, que associações vão ser possíveis de ser feitas e como nós vamos ser capazes de indicar plágios que podem acontecer a partir de agora — seja em artigos acadêmicos, artigos de jornais ou trabalho de escolas e universidades”, alerta Nina da Hora.

O diretor do IP.rec aponta que há um aspecto “obscuro” nessa dinâmica em que uma tecnologia nem sempre inovadora traz uma nova aplicação que causa um boom de produção de dados. Caso a empresa que detém essa grande base feche, por exemplo, o que será feito com ela?

“Pode servir para alimentar outra aplicação”, considera. Um modelo treinado no intuito lúdico pode ser posteriormente utilizado em algo que reproduza racismo ou transfobia, exemplifica. “Um desafio que a tecnologia nos impõe é que essas questões são sistêmicas, nunca têm começo, meio e fim”, complementa o advogado.

A cientista da computação também chama atenção para o perfil dos países em que essas aplicações costumam viralizar: os países emergentes. No texto “Como queremos posicionar o cenário de tecnologia responsável nos próximos 10 anos”, publicado no site MIT Technology Review, Nina da Hora fala sobre eles serem constantemente utilizados como laboratórios extrativistas nos quais nações mais desenvolvidas buscam dados.

“São países emergentes, então a colonização algorítmica vai acontecer porque existem os que têm mais poder aquisitivo para investir em uma infraestrutura e fazer com que os dados desses países não fiquem neles. Vão estar sempre em data centers e em ambientes externos a eles. Como nós temos acesso a isso? Nós não sabemos. Não sabemos nem como solicitar”, aponta.

Nesse contexto, ambos os especialistas reforçam a importância da regulação da inteligência artificial no Brasil. Um dos pontos destacados por Fernandes, por exemplo, é que deve ser assegurado o direito de as pessoas saberem, desde o início da interação, que estão “conversando” com uma IA.

O diretor do IP.rec defende ainda que a responsabilidade pelo uso da tecnologia seja dividida entre os usuários e as empresas. “Isso acontece na indústria de minério, de óleo, farmacêutica. Isso precisa ser discutido, e a sociedade precisa participar.” Ele também aponta que, inclusive, é mais seguro para o próprio setor que haja uma referência para decisões legais envolvendo inteligência artificial. “É benéfico para todo mundo”, afirma.

Em julho de 2021, a Câmara dos Deputados aprovou o Projeto de Lei nº 21/2020, sobre Inteligência Artificial, que tramitou em regime de urgência. Com críticas de especialistas, o texto seguiu para o Senado, e em 17 de fevereiro de 2022 foi instituída a Comissão de Juristas responsável por subsidiar a elaboração de substitutivo sobre inteligência artificial no Brasil (CJSUBIA), que entregou o Relatório Final e encerrou o trabalho em 6 de dezembro do ano passado.

Nina da Hora, que foi uma das especialistas ouvidas pela Comissão de Juristas, acredita que esse processo, até o momento, foi “só um primeiro passo” e que a regulação não deve generalizar a influência que essas ferramentas podem ter na sociedade. “Acho que vamos ter que entender essas inteligências artificiais por voz, texto e imagens de maneiras um pouco diferentes, porque o impacto delas vem de maneiras diferentes”, afirma.

Destacando o histórico brasileiro na criação de leis com participação popular, como no caso do Marco Civil da Internet, André Lucas Fernandes também defende que o texto seja mais discutido. “Somos estudo de caso, como exemplo de boas práticas nesse sentido. Teve a discussão da comissão de juristas, mas achamos que ainda é preciso discutir mais o texto. Agora deveria ter uma nova rodada de consultas públicas.”

Discussões sobre os impactos e os desafios da tecnologia para a sociedade